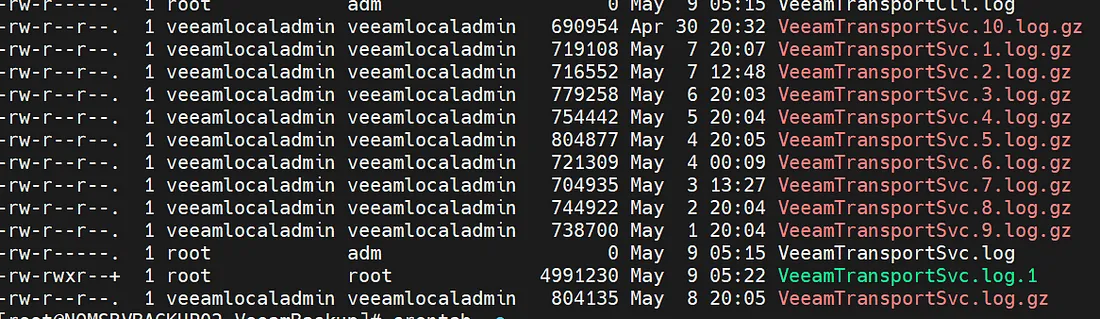

ciao a tutti, un cliente con un ambiente molto grande mi ha fatto notare la crescita importante della dir

/var/log/VeeamBackup

effettivamente mi pare che ci sia una rotazione in essere (ma non la trovo in /etc/logrotate.d) ma i file siano mantenuti indefinitamente.

Ho pensato a questa soluzione con una riga in crontab

0 11 * * * find /var/log/VeeamBackup/ -type f -user veeamlocaladmin -mtime +30 -deleteper cancellare solo i file compressi “archiviati” più vecchi di 30 gg.

Che ne pensate? come avete risolto in casi analoghi?

https://blog.tinivelli.com/huge-veeam-logs-directory-in-an-hardened-repo-fbdbafb8acdd